https://lejournal.cnrs.fr/articles/les-defis-dune-ia-frugale

Alors que le développement de l’intelligence artificielle (IA) va réclamer toujours plus d’énergie, comment limiter son impact sur le changement climatique ?

L’engouement grandissant pour l’intelligence artificielle, notamment à travers l’utilisation d’agents conversationnels de type ChatGPT, n’a de cesse d’alourdir la facture énergétique mondiale du numérique. La quête d’une IA plus frugale fait de plus en plus d’émules parmi les chercheurs, conscients qu’il s’agit d’un sujet névralgique dans le contexte climatique actuel. Mais avant tout, quel est le véritable poids de l’IA ?

« Le numérique étant partout, l’évaluation de son impact est un sujet compliqué, affirme Denis Trystram, professeur à l’Institut polytechnique de Grenoble et membre du Laboratoire d’informatique de Grenoble1 (LIG). Par exemple, faut-il entrer la consommation des véhicules Tesla dans la catégorie du transport ou du numérique ? Est-ce que l’énergie utilisée pour la commande de billets en ligne doit aller dans le bilan du transport ferroviaire ou rester dans celui d’Internet ? En général, on estime que le numérique représente de 4 à 5 % de la demande énergétique mondiale. Ce chiffre est cependant voué à augmenter de plus en plus vite, notamment à cause du développement de l’IA. Déjà plus consommateur que l’aviation civile, le numérique pourrait peser autant que le secteur des transports dès 2025. À eux seuls, les datacenters (centre de données) absorbent 1 % de l’électricité planétaire. »

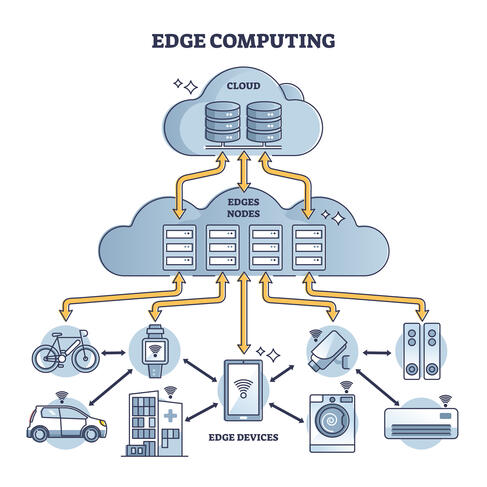

Denis Trystram, qui est également titulaire d’une chaire à l’institut MIAI2 Grenoble Alpes, a longtemps travaillé à l’optimisation des systèmes distribués, c’est-à-dire des réseaux d’appareils mobiles tels que ceux de l’internet des objets (IoT). D’abord menées sur les performances de calcul, ses recherches ont progressivement évolué vers une réduction de la consommation énergétique et de l’impact environnemental du numérique et de l’apprentissage automatique. Le chercheur s’est penché sur le concept d’edge computing (ou informatique en périphérie de réseau), notamment via le programme de recherche Edge Intelligence3.

L’edge computing a vocation à décentraliser le stockage de nos données dans le but de moins faire appel à de gros datacenters, gourmands en énergie et en eau.

Contrairement aux systèmes classiques où les données sont centralisées et exploitées dans un nombre limité de serveurs puissants, l’edge computing propose un stockage et un traitement des données au plus près de l’endroit où elles ont été produites. La circulation de grandes masses d’informations s’en trouve ainsi réduite. De plus, bien que ces objets connectés soient beaucoup moins puissants que des datacenters, ils sont aussi et surtout moins coûteux et moins énergivores. Certes, il n’est pas possible d’y entraîner des modèles d’IA complexes, mais on peut néanmoins y faire tourner des algorithmes déjà opérationnels.

Face à la prise de conscience du poids du numérique dans la crise climatique, plusieurs réactions sont possibles. La plus simple, celle des géants du Web, est de continuer comme avant, tout en affirmant que les centres de données sont plus verts.

« Avec Edge Intelligence, nous identifions les cas de figure où le traitement local est une option plus frugale que de tout centraliser, poursuit Denis Trystram. Je produis également des outils pour mesurer la consommation des IA, afin d’informer les utilisateurs. » En effet, il est important de garder en tête que la plupart des « données utilisées sur Internet n’ont généralement pas été générées au sein des datacenters : elles proviennent d’appareils photo, d’ordinateurs ou encore de téléphones portables, explique le chercheur de Grenoble. Ainsi, il semble pertinent de les employer au plus près de la machine qui les a engendrées pour soulager les réseaux et éviter de faire transiter des données dont on ne sait pas encore si elles serviront. »

En l’absence de solution technique miracle qui gommera d’un coup la demande énergétique du numérique, la responsabilisation des usagers est vue comme une piste essentielle. Et pour cela, il est nécessaire de savoir ce que coûte réellement des pratiques à présent courantes, comme regarder en haute définition une vidéo sur son téléphone.

De plus, Denis Trystram collabore avec des philosophes, des sociologues et des économistes expérimentaux. Leurs outils, issus des sciences humaines et sociales, aident à y voir plus clair et à analyser les problèmes dans leur globalité. « Face à la prise de conscience du poids du numérique dans la crise climatique, plusieurs réactions sont possibles, explique Denis Trystram. La plus simple, celle des géants du Web, est de continuer comme avant, tout en affirmant que les centres de données sont plus verts. Or, le zéro carbone n’est jamais atteint si l’on prend en compte tous les paramètres matériels. L’optimisation des performances permet de réduire jusqu’à 30 à 40 % de l’impact énergétique des grandes plateformes numériques, mais ces gains sont effacés par l’accélération des usages. Pour aller plus loin, il faut donc remettre en cause le modèle tout entier, interroger les comportements et déterminer quels usages sont véritablement nécessaires. »

Un avis partagé par Gilles Sassatelli, directeur de recherche au Laboratoire d’informatique, de robotique et de microélectronique de Montpellier4 où il travaille sur les IA pour les systèmes embarqués et l’alimentation de vastes systèmes de calcul par des énergies renouvelables. Il exploite également les propriétés physiques des matériaux afin d’obtenir des composants électroniques capables de gérer des tâches qui sont pour l’instant effectuées numériquement. L’idée étant de décharger l’IA de certains calculs. Enfin, tout comme Denis Trystram, il étudie le edge computing. « Il ne faut pas se leurrer, l’IA est considérée comme un vecteur de croissance économique par beaucoup de secteurs d’activité, affirme Gilles Sassatelli. En l’état, tous les progrès scientifiques en l’efficacité énergétique des IA seront annulés par effet rebond. » Au lieu d’être pérennisées, les économies réalisées sont en effet perçues comme une opportunité d’utiliser davantage les outils numériques.

Les objets connectés du quotidien pourraient devenir nos prochains petits « datacenters ». Une façon de consommer et stocker nos données localement pour une meilleure gestion des flux et de l’énergie, qui renforcerait cependant l’usage des outils numérique.

L’humanité reste sur la recette qui veut que plus un modèle est gros, meilleur il est. Or c’est une manière très inefficace de procéder. On sait aussi qu’il existe une marge de progression très importante en termes d’efficacité, même si on n’a pas encore trouvé les clés scientifiques pour déverrouiller ce potentiel. À titre d’exemple, on peut réaliser des économies significatives en identifiant les endroits où l’on peut réduire drastiquement la précision des calculs dans les réseaux de neurones, mais ce n’est qu’un premier pas.

https://lejournal.cnrs.fr/articles/quand-van-eyck-inventait-la-realite-virtuelle

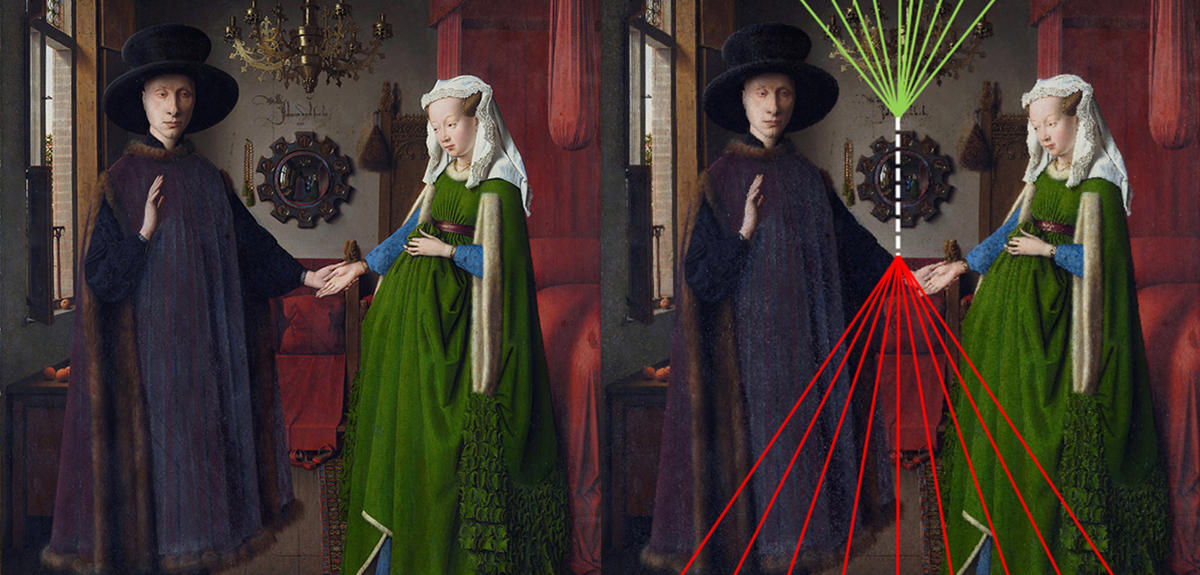

16.08.2021, par Martin Koppe Analyse des points de fuite du tableau Les Époux Arnolfini, huile sur toile de Jan Van Eyck, 1434, conservé à la National Gallery à Londres. Jan Van Eyck/National Gallery, London/Wikimedia Commons Partager À l’aide de l’informatique, un chercheur est parvenu à élucider la technique de la perspective du peintre flamand Van Eyck, alors qu’elle était jusqu’ici considérée comme l’apanage des artistes italiens de la Renaissance.

Analyse des points de fuite du tableau Les Époux Arnolfini, huile sur toile de Jan Van Eyck, 1434, conservé à la National Gallery à Londres. Jan Van Eyck/National Gallery, London/Wikimedia Commons Partager À l’aide de l’informatique, un chercheur est parvenu à élucider la technique de la perspective du peintre flamand Van Eyck, alors qu’elle était jusqu’ici considérée comme l’apanage des artistes italiens de la Renaissance.

L’histoire des lignes n’a rien de linéaire, l’importance dans l’art des proportions et de la profondeur a fortement fluctué selon les siècles et les cultures. À la Renaissance, la précision géométrique de la perspective s’est imposée comme un élément essentiel des tableaux et des fresques, mais aussi en architecture ou pour la sculpture. La question a été en particulier traitée par l’historien de l’art Erwin Panofsky, figure tutélaire de la discipline, dans son essai de 1927 La perspective comme forme symbolique.

« Au début de la Renaissance italienne, Brunelleschi1 et Alberti2 ont décrit la perspective dans l’art comme une transcription géométrique des lois de l’optique, explique Gilles Simon, maître de conférences à l’université de Lorraine et chercheur au Laboratoire lorrain de recherche en informatique et ses applications (LORIA)3. Ils sont pour cela partis des travaux d’Euclide, en y ajoutant un plan de projection entre l’objet représenté et l’œil du spectateur. »

Une perspective rigoureuse se construit à partir de plusieurs règles mathématiques, comme la présence dans une œuvre d’art de lignes de fuite convergeant en un point unique. Une technique née des maîtres du Quattrocento, et qui semblait inconnue des autres artistes avant que l’influence de la Renaissance italienne ne parvienne jusqu’à eux. Détail de l’Adoration de l’Agneau mystique ou Autel de Gand, achevé en 1432 par Jan Van Eyck et conservé dans la cathédrale Saint-Bavon de Gand. Wikimédia commons Partager

Détail de l’Adoration de l’Agneau mystique ou Autel de Gand, achevé en 1432 par Jan Van Eyck et conservé dans la cathédrale Saint-Bavon de Gand. Wikimédia commons Partager

Ainsi, pour Panofsky, le peintre flamand Jan Van Eyck (1390-1441) tentait de s’approcher, de manière empirique, d’une perspective la plus correcte et réaliste possible, mais ignorait les lois géométriques y menant. Van Eyck était pourtant célèbre pour sa rigueur. Il est un des premiers à avoir utilisé la peinture à huile, une technique dont il a élaboré de nouvelles recettes pour obtenir une peinture qui sèche moins vite, et qui lui permettait donc d’apporter plus de détails.

« En allant admirer le retable de Gand, peint par Van Eyck, j’ai été très impressionné par la perspective sur la fontaine du panneau de l’Adoration de l’Agneau mystique, se souvient Gilles Simon. Je me suis dit qu’il fallait creuser. » Le chercheur est en effet un spécialiste de la détection des lignes et des points de fuite dans les photographies et les vidéos. Ses algorithmes servent par exemple à rectifier les objets déformés par un mauvais angle de vue, ou à guider dans l’espace les systèmes de pilotage autonome.

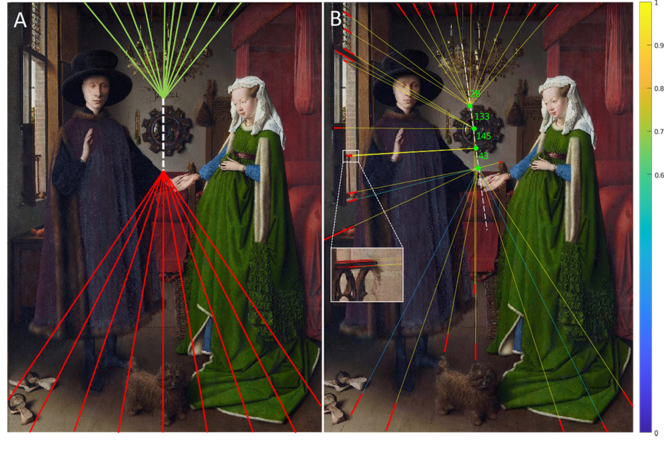

« Dès que je vais dans un musée, je vérifie malgré moi si la perspective des tableaux semble correcte ou non », s’amuse Gilles Simon. Il a alors adapté certains de ses algorithmes de détection de points de fuite afin de les déployer sur cinq tableaux de Van Eyck, peints entre 1432 et 1439. On retrouve parmi eux son œuvre la plus célèbre, la peinture sur bois des Époux Arnolfini dont la perspective est l’objet d’un bon siècle de débats. Reconstruction manuelle (A) et à l’aide de vision artificielle (B) des lignes de fuite du tableau “Les époux Arnolfini” (1434, 82.2 × 60 cm, National Gallery) Jan Van Eyck/National Gallery, London/Wikimedia Commons Partager

Reconstruction manuelle (A) et à l’aide de vision artificielle (B) des lignes de fuite du tableau “Les époux Arnolfini” (1434, 82.2 × 60 cm, National Gallery) Jan Van Eyck/National Gallery, London/Wikimedia Commons Partager

En effet, l’identification de ce qui compte ou non comme une ligne de fuite reste très subjective, chaque historien de l’art peut ajouter ou en exclure certaines, y compris inconsciemment. « J’ai intégré l’incertitude dans les mesures des arêtes, afin d’obtenir une carte probabiliste des points de fuite possibles, détaille Gilles Simon. J’ai également utilisé une ancienne méthode informatique pour faire ressortir les pics de probabilités les plus significatifs. »

Il a ainsi montré que les Époux Arnolfini est composé de quatre bandes horizontales, possédant chacune un point centrique régulièrement espacé le long d’un axe incliné parcourant le tableau dans sa hauteur. À l’intérieur de ces bandes, la perspective obéit parfaitement aux lois géométriques dont on pensait que seuls quelques maîtres italiens avaient alors le secret.

Si cette organisation n’a pas été retrouvée dans l’Adoration de l’Agneau mystique, les cinq tableaux étudiés partagent tous un schéma en arête de poisson qui n’avait jamais été identifié avant les travaux de Gilles Simon. Ces derniers ont été rendus publics lors de la conférence internationale ACM in Computer Graphics and Interactive Techniques, qui s’est déroulée du 9 au 13 août 2021.

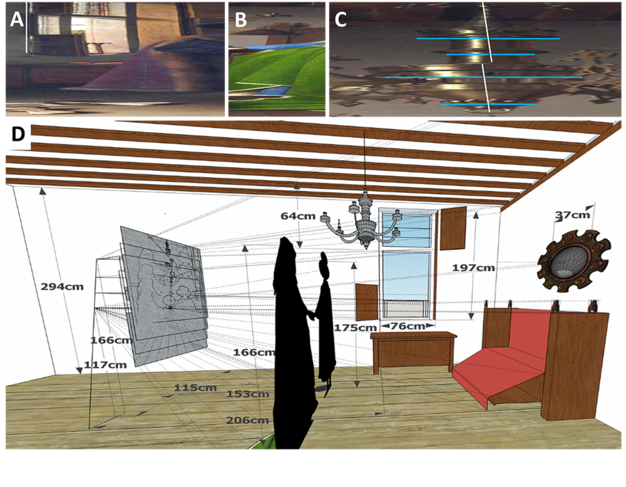

Gilles Simon y présente également une reconstitution en 3D de la perspective multiple du tableau, et explique comment Van Eyck s’y est pris. Le peintre aurait ainsi utilisé une véritable « machine à perspective » composée de quatre œilletons équidistants, un pour chaque bande, disposés verticalement. Reconstruction tridimensionnelle de la chambre des Arnolfinis à partir des effets de parallaxe du tableau. Université de Lorraine. Partager

Reconstruction tridimensionnelle de la chambre des Arnolfinis à partir des effets de parallaxe du tableau. Université de Lorraine. Partager

« Il commence par dessiner une première bande, tout en haut ou tout en bas, à travers un œilleton, détaille Gilles Simon. Mais à cause du phénomène de parallaxe, l’image se décale lorsqu’il passe au second œilleton. Il compense cela en suivant un axe du décor, puis fait de même avec les bandes restantes. La géométrie 3D empêche cependant un alignement parfait. On aperçoit ainsi encore un peu de décalage dans le tableau final, en particulier au niveau du chandelier dont l’aspect s’explique par le fait qu’il se tienne à cheval sur deux bandes. »

Si Brunelleschi employait autour de 1420 un panneau de bois percé d’un œilleton, Van Eyck n’en reste pas moins un des pionniers de l’utilisation de systèmes optiques pour rendre la perspective et tenir compte de notre vision stéréoscopique. Cette approche peut être considérée comme les prémices de la réalité virtuelle, et sera simplifiée soixante-dix ans plus tard par Léonard de Vinci.

Fort de sa découverte, Gilles Simon applique à présent sa méthode à d’autres œuvres, au-delà de Van Eyck, et s’attend à de nouvelles surprises quant à l’usage de la perspective. Il souligne également que sa technique pourrait aider à authentifier certains tableaux.

Les algorithmes de Gilles Simon restent cependant difficiles d’accès pour qui n’est pas spécialiste, mais il souhaite concevoir une interface qui les rendra utilisables par les historiens de l’art. « Ils sont encore peu nombreux à s’intéresser à l’informatique, déplore Gilles Simon, mais j’espère que des travaux comme les miens vont les pousser à employer nos outils. Cela fait une bonne trentaine d’années que nous avons développé des solutions qui pourraient les aider à résoudre leurs problèmes géométriques. » ♦